Scrapy快速入门

Scrapy框架模块功能:

Scrapy Engine(引擎):Scrapy框架的核心部分。负责在Spider和ItemPipeline、Downloader、Scheduler中间通信、传递数据等。

Spider(爬虫):发送需要爬取的链接给引擎,最后引擎把其他模块请求回来的数据再发送给爬虫,爬虫就去解析想要的数据。这个部分是我们开发者自己写的,因为要爬取哪些链接,页面中的哪些数据是我们需要的,都是由程序员自己决定。

解析Downloader返回的响应(Response)

产生爬取项(scraped item)

产生额外的爬取请求(Request)

Scheduler(调度器):负责接收引擎发送过来的请求,并按照一定的方式进行排列和整理,负责调度请求的顺序等。

Downloader(下载器):负责接收引擎传过来的下载请求,然后去网络上下载对应的数据再交还给引擎。

Item Pipeline(管道):负责将Spider(爬虫)传递过来的数据进行保存。具体保存在哪里,应该看开发者自己的需求。

Downloader Middlewares(下载中间件):可以扩展下载器和引擎之间通信功能的中间件。

Spider Middlewares(Spider中间件):可以扩展引擎和爬虫之间通信功能的中间件。

目的:对请求和爬取项的再处理 功能:修改、丢弃、新增请求或爬取项

用户可以编写配置代码

安装和文档:

- 安装:通过

pip install scrapy即可安装。 - Scrapy官方文档:http://doc.scrapy.org/en/latest

- Scrapy中文文档:http://scrapy-chs.readthedocs.io/zh_CN/latest/index.html

注意:

- 在

ubuntu上安装scrapy之前,需要先安装以下依赖:

sudo apt-get install python3-dev build-essential python3-pip libxml2-dev libxslt1-dev zlib1g-dev libffi-dev libssl-dev,然后再通过pip install scrapy安装。 - 如果在

windows系统下,提示这个错误ModuleNotFoundError: No module named 'win32api',那么使用以下命令可以解决:pip install pypiwin32。

requests库和Scrapy爬虫的比较

两者都可以进行页面请求和爬取,Python爬虫的两个重要技术路线

两者可用性都好,文档丰富,入门简单

两者都没用处理js、提交表单、应对验证码等功能(可扩展)

快速入门:

创建项目:

要使用Scrapy框架创建项目,需要通过命令来创建。首先进入到你想把这个项目存放的目录。然后使用以下命令创建:

scrapy startproject [项目名称]

为什么Scrapy采用命令行创建和运行爬虫

命令行(不是图形界面)更容易自动化,适合脚本控制。本质上,Scrapy是给程序员用的,功能(而不是界面)更重要

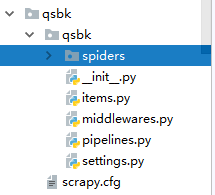

目录结构介绍:

以下介绍下主要文件的作用:

- items.py:用来存放爬虫爬取下来数据的模型。

- middlewares.py:用来存放各种中间件的文件。

- pipelines.py:用来将

items的模型存储到本地磁盘中。 - settings.py:本爬虫的一些配置信息(比如请求头、多久发送一次请求、ip代理池等)。

- scrapy.cfg:项目的配置文件。

- spiders包:以后所有的爬虫,都是存放到这个里面。

使用Scrapy框架爬取糗事百科段子:

使用命令创建一个爬虫:

scrapy gensipder qsbk "qiushibaike.com"

创建了一个名字叫做qsbk的爬虫,并且能爬取的网页只会限制在qiushibaike.com这个域名下。

爬虫代码解析:

import scrapy

class QsbkSpider(scrapy.Spider):

name = 'qsbk'

allowed_domains = ['qiushibaike.com']

start_urls = ['http://qiushibaike.com/']

def parse(self, response):

pass

其实这些代码我们完全可以自己手动去写,而不用命令。只不过是不用命令,自己写这些代码比较麻烦。

要创建一个Spider,那么必须自定义一个类,继承自scrapy.Spider,然后在这个类中定义三个属性和一个方法。

- name:这个爬虫的名字,名字必须是唯一的。

- allow_domains:允许的域名。爬虫只会爬取这个域名下的网页,其他不是这个域名下的网页会被自动忽略。

- start_urls:爬虫从这个变量中的url开始。

- parse:引擎会把下载器下载回来的数据扔给爬虫解析,爬虫再把数据传给这个

parse方法。这个是个固定的写法。这个方法的作用有两个,第一个是提取想要的数据。第二个是生成下一个请求的url。

修改settings.py代码:

在做一个爬虫之前,一定要记得修改setttings.py中的设置。两个地方是强烈建议设置的。

ROBOTSTXT_OBEY设置为False。默认是True。即遵守机器协议,那么在爬虫的时候,scrapy首先去找robots.txt文件,如果没有找到。则直接停止爬取。DEFAULT_REQUEST_HEADERS添加User-Agent。这个也是告诉服务器,我这个请求是一个正常的请求,不是一个爬虫。

完成的爬虫代码:

-

爬虫部分代码:

import scrapy

from abcspider.items import QsbkItem

class QsbkSpider(scrapy.Spider):

name = 'qsbk'

allowed_domains = ['qiushibaike.com']

start_urls = ['https://www.qiushibaike.com/text/']

def parse(self, response):

outerbox = response.xpath("//div[@id='content-left']/div")

items = []

for box in outerbox:

author = box.xpath(".//div[contains(@class,'author')]//h2/text()").extract_first().strip()

content = box.xpath(".//div[@class='content']/span/text()").extract_first().strip()

item = QsbkItem()

item["author"] = author

item["content"] = content

items.append(item)

return items

-

items.py部分代码:

import scrapy

class QsbkItem(scrapy.Item):

author = scrapy.Field()

content = scrapy.Field()

-

pipeline部分代码:

import json

class AbcspiderPipeline(object):

def __init__(self):

self.items = []

def process_item(self, item, spider):

self.items.append(dict(item))

print("="*40)

return item

def close_spider(self,spider):

with open('qsbk.json','w',encoding='utf-8') as fp:

json.dump(self.items,fp,ensure_ascii=False)

运行scrapy项目:

运行scrapy项目。需要在终端,进入项目所在的路径,然后scrapy crawl [爬虫名字]即可运行指定的爬虫。如果不想每次都在命令行中运行,那么可以把这个命令写在一个文件中。以后就在pycharm中执行运行这个文件就可以了。比如现在新创建一个文件叫做start.py,然后在这个文件中填入以下代码:

from scrapy import cmdline

cmdline.execute("scrapy crawl qsbk".split())

糗事百科Scrapy爬虫笔记:

1. response是一个"scrapy.http.response,html.HtmlResponse"对象。可以执行" xpah和"css语法来提取数据。

2,提取出来的数据,是一个"Selector"或者是一个"SelectorList对象。如果想要获取其中的字符串。那么应该执行"getall'或者”get”方法。3. 3、3、getall方法:获取"Selector`中的所有文本。返回的是一个列表。

4. get方法:获取的是"Selector"中的第一个文本。返回的是一个str类型。

5,如果数据解析回来,要传给pipline处理。那么可以使用" yield"来返回。或者是收集所有的item。最后统一使用return返回。

6. item:建议在”items.py“中定义好模型。以后就不要使用字典。

7. pipeline:这个是专门用来保存数据的。其中有三个方法是会经常用的。

" open_spider(self,spider)":当爬虫被打开的时候执行。

"process_item(self,item,spider)":当爬虫有item传过来的时候会被调用。* "close_spider(self,spider)":当爬虫关团的时候会被调用。

要激活piplilne,应该在"settings.py中,设置*ITEM_PIPELINES'。示例如下:

JsonItemExporter和JsonLinesItemExporter

保存json数据的时候,可以使用这两个类,让操作变得得更简单。

1. "JsonItemExporter":这个是每次把数据添加到内存中。最后统一写入到磁盘中。好处是,存储的数据是一个满足json规则的数据。坏处是如果数据量比较大,那么比较耗内存。示例代码如下:

2.’3sonLinesItemExporter':这个是每次调用"export_item`的时候就把这个item存储到硬盘中,坏处是每一个字典是一行,整个文件不是一个满足json格式的文件。好处是每次处理数据的时候就直接存储到了硬盘中,这样不会耗内存,数据也比较安全。

CrawlSpider

在上一个糗事百科的爬虫案例中。我们是自己在解析完整个页面后获取下一页的url,然后重新发送一个请求。有时候我们想要这样做,只要满足某个条件的url,都给我进行爬取。那么这时候我们就可以通过CrawlSpider来帮我们完成了。CrawlSpider继承自Spider,只不过是在之前的基础之上增加了新的功能,可以定义爬取的url的规则,以后scrapy碰到满足条件的url都进行爬取,而不用手动的yield Request。

CrawlSpider爬虫:

创建CrawlSpider爬虫:

之前创建爬虫的方式是通过scrapy genspider [爬虫名字] [域名]的方式创建的。如果想要创建CrawlSpider爬虫,那么应该通过以下命令创建:

scrapy genspider -t crawl [爬虫名字] [域名]

LinkExtractors链接提取器:

使用LinkExtractors可以不用程序员自己提取想要的url,然后发送请求。这些工作都可以交给LinkExtractors,他会在所有爬的页面中找到满足规则的url,实现自动的爬取。以下对LinkExtractors类做一个简单的介绍:

class scrapy.linkextractors.LinkExtractor(

allow = (),

deny = (),

allow_domains = (),

deny_domains = (),

deny_extensions = None,

restrict_xpaths = (),

tags = ('a','area'),

attrs = ('href'),

canonicalize = True,

unique = True,

process_value = None

)

主要参数讲解:

- allow:允许的url。所有满足这个正则表达式的url都会被提取。

- deny:禁止的url。所有满足这个正则表达式的url都不会被提取。

- allow_domains:允许的域名。只有在这个里面指定的域名的url才会被提取。

- deny_domains:禁止的域名。所有在这个里面指定的域名的url都不会被提取。

- restrict_xpaths:严格的xpath。和allow共同过滤链接。

Rule规则类:

定义爬虫的规则类。以下对这个类做一个简单的介绍:

class scrapy.spiders.Rule(

link_extractor,

callback = None,

cb_kwargs = None,

follow = None,

process_links = None,

process_request = None

)

主要参数讲解:

- link_extractor:一个

LinkExtractor对象,用于定义爬取规则。 - callback:满足这个规则的url,应该要执行哪个回调函数。因为

CrawlSpider使用了parse作为回调函数,因此不要覆盖parse作为回调函数自己的回调函数。 - follow:指定根据该规则从response中提取的链接是否需要跟进。

- process_links:从link_extractor中获取到链接后会传递给这个函数,用来过滤不需要爬取的链接。

微信小程序社区CrawlSpider案例

Scrapy Shell

我们想要在爬虫中使用xpath、beautifulsoup、正则表达式、css选择器等来提取想要的数据。但是因为scrapy是一个比较重的框架。每次运行起来都要等待一段时间。因此要去验证我们写的提取规则是否正确,是一个比较麻烦的事情。因此Scrapy提供了一个shell,用来方便的测试规则。当然也不仅仅局限于这一个功能。

打开Scrapy Shell:

打开cmd终端,进入到Scrapy项目所在的目录,然后进入到scrapy框架所在的虚拟环境中,输入命令scrapy shell [链接]。就会进入到scrapy的shell环境中。在这个环境中,你可以跟在爬虫的parse方法中一样使用了。

CrawlSpider:

需要使用"LinkExtractor和“Rule".这两个东西决定爬虫的具体走向。

1. allow设置规则的方法:要能够限制在我们想要的url上面。不要跟其他的ur1产生相同

的正则表达式即可。

2.什么情况下使用follon:如果在爬取页面的时候,需要将满足当前条件的ur1再进行跟

进,那么就设置为True.否则设置为Fasle.

3.什么情况下该指定callback:如果这个url对应的页面,只是为了获取更多的url,并不

需要里面的数据,那么可以不指定callback.如果想要获取ur1对应页面中的数据,那么就

需要指定-个callback

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)