JSON支持数据格式:

- 对象(字典)。使用花括号。

- 数组(列表)。使用方括号。

- 整形、浮点型、布尔类型还有null类型。

- 字符串类型(字符串必须要用双引号,不能用单引号)。

Python 编码为 JSON 类型转换对应表:

| Python | JSON |

|---|

| dict | object |

| list, tuple | array |

| str | string |

| int, float, int- & float-derived Enums | number |

| True | true |

| False | false |

| None | null |

多个数据之间使用逗号分开。

注意:json本质上就是一个字符串。

Python3 中可以使用 json 模块来对 JSON 数据进行编解码,它包含了两个函数:

- json.dumps(): 对数据进行编码。

- json.loads(): 对数据进行解码。

字典和列表转JSON:

import json

books = [

{

'title': '钢铁是怎样练成的',

'price': 9.8

},

{

'title': '红楼梦',

'price': 9.9

}

]

json_str = json.dumps(books,ensure_ascii=False)

print(json_str)

因为json在dump的时候,只能存放ascii的字符,因此会将中文进行转义,这时候我们可以使用ensure_ascii=False关闭这个特性。

在Python中。只有基本数据类型才能转换成JSON格式的字符串。也即:int、float、str、list、dict、tuple。

将json数据直接dump到文件中:

json模块中除了dumps函数,还有一个dump函数,这个函数可以传入一个文件指针,直接将字符串dump到文件中。示例代码如下:

books = [

{

'title': '钢铁是怎样练成的',

'price': 9.8

},

{

'title': '红楼梦',

'price': 9.9

}

]

with open('a.json','w') as fp:

json.dump(books,fp)

将一个json字符串load成Python对象:

json_str = '[{"title": "钢铁是怎样练成的", "price": 9.8}, {"title": "红楼梦", "price": 9.9}]'

books = json.loads(json_str,encoding='utf-8')

print(type(books))

print(books)

直接从文件中读取json:

import json

with open('a.json','r',encoding='utf-8') as fp:

json_str = json.load(fp)

print(json_str)

csv文件处理

读取csv文件:

import csv

with open('stock.csv','r') as fp:

reader = csv.reader(fp)

titles = next(reader)

for x in reader:

print(x)

这样操作,以后获取数据的时候,就要通过下表来获取数据。如果想要在获取数据的时候通过标题来获取。那么可以使用DictReader。示例代码如下:

import csv

with open('stock.csv','r') as fp:

reader = csv.DictReader(fp)

for x in reader:

print(x['turnoverVol'])

写入数据到csv文件:

写入数据到csv文件,需要创建一个writer对象,主要用到两个方法。一个是writerow,这个是写入一行。一个是writerows,这个是写入多行。示例代码如下:

import csv

headers = ['name','age','classroom']

values = [

('zhiliao',18,'111'),

('wena',20,'222'),

('bbc',21,'111')

]

with open('test.csv','w',newline='') as fp:

writer = csv.writer(fp)

writer.writerow(headers)

writer.writerows(values)

也可以使用字典的方式把数据写入进去。这时候就需要使用DictWriter了。示例代码如下:

import csv

headers = ['name','age','classroom']

values = [

{"name":'wenn',"age":20,"classroom":'222'},

{"name":'abc',"age":30,"classroom":'333'}

]

with open('test.csv','w',newline='') as fp:

writer = csv.DictWriter(fp,headers)

writer = csv.writeheader()

writer.writerow({'name':'zhiliao',"age":18,"classroom":'111'})

writer.writerows(values)

MySQL数据库操作

安装mysql:

- 在官网:https://dev.mysql.com/downloads/windows/installer/5.7.html

- 如果提示没有

.NET Framework框架。那么就在提示框中找到下载链接,下载一个就可以了。 - 如果提示没有

Microsoft Virtual C++ x64(x86),那么百度或者谷歌这个软件安装即可。 - 如果没有找到。那么私聊我。

navicat:

navicat是一个操作mysql数据库非常方便的软件。使用他操作数据库,就跟使用excel操作数据是一样的。

安装驱动程序:

Python要想操作MySQL。必须要有一个中间件,或者叫做驱动程序。驱动程序有很多。比如有mysqldb、mysqlclient、pymysql等。在这里,我们选择用pymysql。安装方式也是非常简单,通过命令pip install pymysql即可安装。

数据库连接:

数据库连接之前。首先先确认以下工作完成,这里我们以一个pymysql_test数据库.以下将介绍连接mysql的示例代码:

import pymysql

db = pymysql.connect(

host="127.0.0.1",

user='root',

password='root',

database='student',

port=3306

)

cursor = db.cursor()

cursor.execute("select 1")

data = cursor.fetchone()

print(data)

db.close()

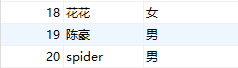

插入数据:

import pymysql

db = pymysql.connect(

host="127.0.0.1",

user='root',

password='root',

database='student',

port=3306

)

cursor = db.cursor()

sql = """

insert into student(

stuno,stuname,stusex

)

values(18,'abc','女');

"""

cursor.execute(sql)

db.commit()

db.close()

如果在数据还不能保证的情况下,可以使用以下方式来插入数据:

sql = """

insert into student(

stuno,stuname,stusex

)

values(%s,%s,%s);

"""

cursor.execute(sql,(20,'spider','男'))

查找数据:

使用pymysql查询数据。可以使用fetch*方法。

fetchone():这个方法每次之获取一条数据。fetchall():这个方法接收全部的返回结果。fetchmany(size):可以获取指定条数的数据。

示例代码如下:

import pymysql

db = pymysql.connect(

host="127.0.0.1",

user='root',

password='root',

database='student',

port=3306

)

cursor = db.cursor()

sql = """

select * from student

"""

cursor.execute(sql)

while True:

result = cursor.fetchone()

if not result:

break

print(result)

db.close()

或者是直接使用fetchall,一次性可以把所有满足条件的数据都取出来:

cursor = db.cursor()

sql = """

select * from user

"""

cursor.execute(sql)

results = cursor.fetchall()

for result in results:

print(result)

db.close()

或者是使用fetchmany,指定获取多少条数据:

cursor = db.cursor()

sql = """

select * from user

"""

cursor.execute(sql)

results = cursor.fetchmany(1)

for result in results:

print(result)

db.close()

删除数据:

sql = """

delete from student where stuno=99

"""

cursor.execute(sql)

db.commit()

db.close()

更新数据:

sql = """

update student set stuname='花花' where stuno=18

"""

cursor.execute(sql)

db.commit()

db.close()

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)