实验5 Spark SQL 编程初级实践

一、实验目的

(1)通过实验掌握Spark SQL的基本编程方法。

(2)熟悉RDD到DataFrame的转化方法。

(3)熟悉利用Spark SQL管理来自不同数据源的数据。

二、实验平台

操作系统:Linux

Spark版本:2.4.5

scala版本:2.11.8

三、实验内容和要求

1.Spark SQL基本操作

将下列JSON格式数据复制到Linux系统中,并保存命名为employee.json。

文件内容如下:

{ "id":1 , "name":" Ella" , "age":36 }

{ "id":2 , "name":"Bob","age":29 }

{ "id":3 , "name":"Jack","age":29 }

{ "id":4 , "name":"Jim","age":28 }

{ "id":4 , "name":"Jim","age":28 }

{ "id":5 , "name":"Damon" }

{ "id":5 , "name":"Damon" }

为employee.json创建DataFrame,并写出Scala语句完成下列操作:

//导入相应的包

import spark.implicits._

//读取文件

val df=spark.read.json("hdfs://master1:9000/spark/employee.json")

(1)查询所有数据;

df.show()

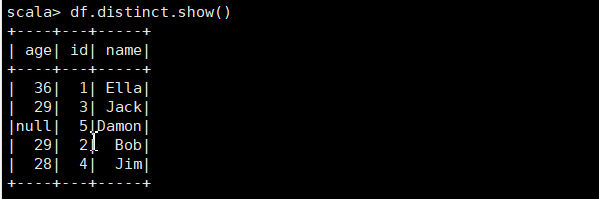

(2)查询所有数据,并去除重复的数据;

df.distinct.show()

(3)查询所有数据,打印时去除id字段;

df.drop("id").show()

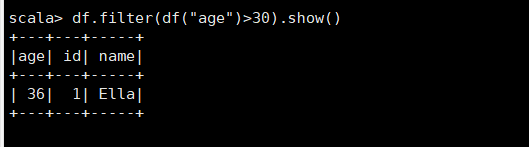

(4)筛选出age>30的记录;

df.filter(df("age")>30).show()

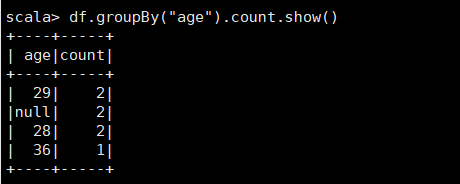

(5)将数据按age分组;

df.groupBy("age").count.show()

(6)将数据按name升序排列;

df.orderBy("name").show()

或者

df.sort(df("name").asc).show()

(7)取出前3行数据;

df.take(3)

df.limit(3).show

(8)查询所有记录的name列,并为其取别名为username;

df.select(df("name").as("username")).show()

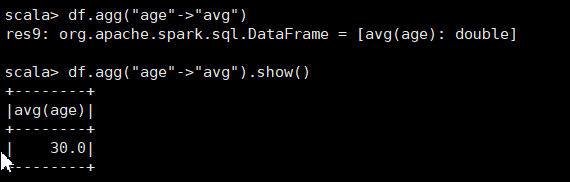

(9)查询年龄age的平均值;

df.agg("age"->"avg").show()

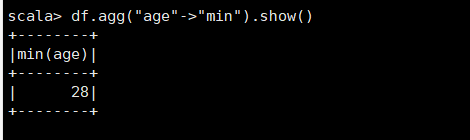

(10)查询年龄age的最小值。

df.agg("age"->"min").show()