参考学习 https://blog.csdn.net/gangchengzhong/article/details/76474129 和 https://my.oschina.net/u/2499632/blog/702814

及 https://blog.csdn.net/lsshlsw/article/details/49155087

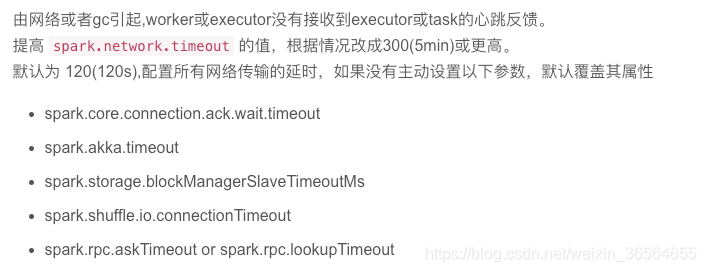

若出现各种timeout,executor lost ,task lost

spark.network.timeout 根据情况改成300(5min)或更高。,默认为 120(120s),配置所有网络传输的延时,如果没有主动设置以下参数,默认覆盖其属性

根据sparkUI中的日志显示出现shuffle FetchFailedException是因为出现了xxx.time.out,那么需要增大spark.network.timeout,从而允许有更多时间去等待心跳响应

本文内容由网友自发贡献,版权归原作者所有,本站不承担相应法律责任。如您发现有涉嫌抄袭侵权的内容,请联系:hwhale#tublm.com(使用前将#替换为@)