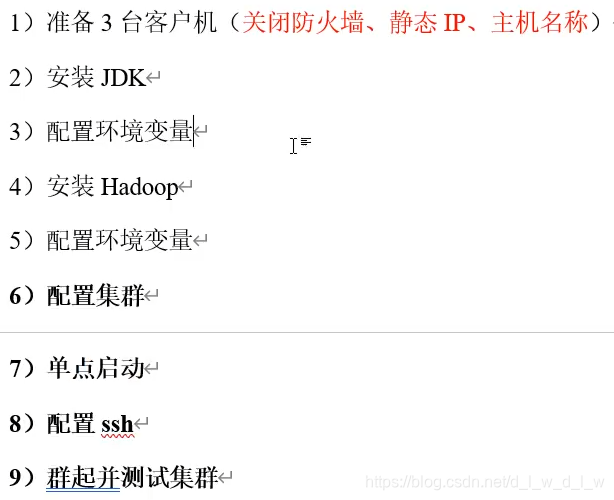

本博客用到的虚拟机客户机已将前五步完成,从6)开始

现有三台客户机,hadoop112,hadoop113,hadoop114。其中hadoop112已完成JDK、Hadoop的安装以及环境变量的配置。所以需要将112上的两者复制到113和114上。

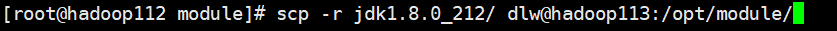

1、将JDK用scp方法从112复制到113上

scp -r jdk1.8.0_212/ dlw@hadoop113:/opt/module/

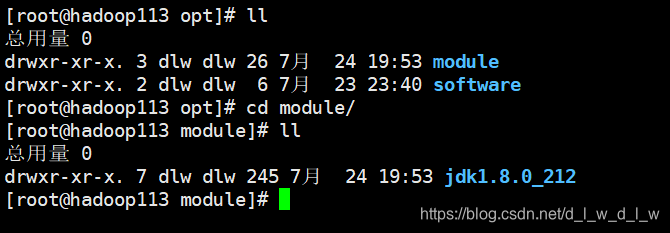

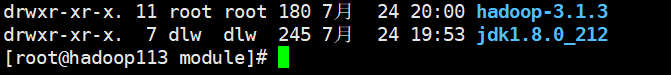

从113上查看结果,显示出JDK已存在则证明复制成功。

2、将hadoop用scp方法从112上拉到113中。

scp -r dlw@hadoop112:/opt/module/hadoop-3.1.3 ./

从113上查看结果,显示出hadoop已存在则证明113从112上拉取相应的数据已成功。

将JDK和hadoop复制到其他客户机上有两种方式1、从a复制到b。(JDK所用方法)2、b向a拉取数据。(Hadoop所用方法)hadoop114与上方操作一样。

xsync集群分发脚本

循环复制文件到所有节点的相同目录之下。(xsync 要同步的文件名称。)

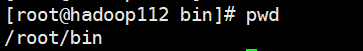

1、在~目录下创建bin文件并打开

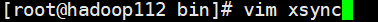

创建脚本

#!/bin/bash

if [ $# -lt 1 ]

then

echo Not Enough Arguement!

exit;

fi

#2. 遍历集群所有机器

for host in hadoop112 hadoop113 hadoop114

do

echo ==================== $host ====================

#3. 遍历所有目录,挨个发送

for file in $@

do

#4. 判度胺文件是否存在

if [ -e $file ]

then

#5. 获取父目录

pdir=$(cd -P $(dirname $file); pwd)

#6. 获取当前文件得名称

fname=$(basename $file)

ssh $host "mkdir -p $pdir"

rsync -av $pdir/$fname $host:$pdir

else

echo $file does not exists!

fi

done

done

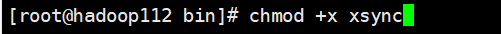

之后再修改脚本xsync具有的执行权限:

chmod +x xsync

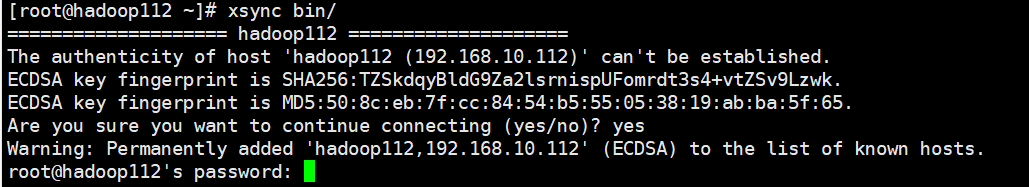

执行完之后即可同步bin文件到113和114

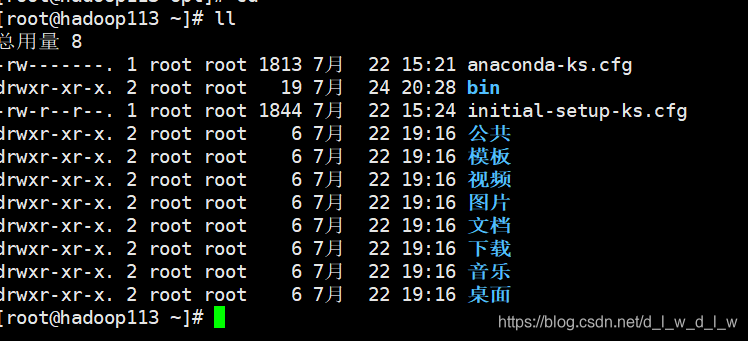

113中显示bin文件,表示xsync执行成功。

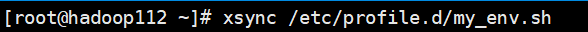

利用xsync经JDK和Hadoop的环境变量快速分发到113和114上。

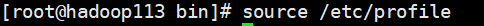

分发完环境变量之后,分别在113和114中进行source指令

source /etc/profile

ssh免密登录配置

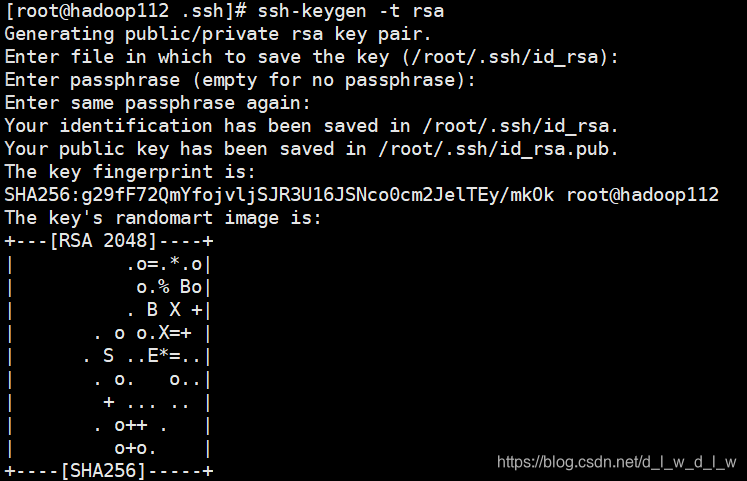

在/root/.ssh路径下输入并不断回车

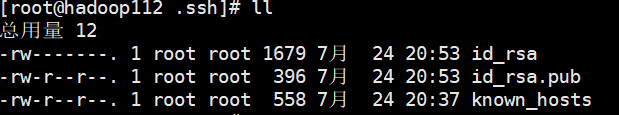

会出现112的公钥和私钥

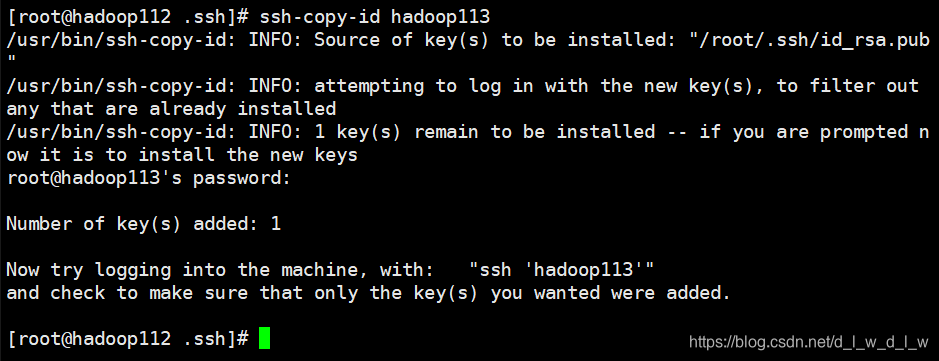

将112的公钥拷贝到113和114上

ssh-copy-id hadoop113

在113和114上重复以上操作。

完成ssh免密登录之后再应用xsync分发脚本往其他服务器传送数据的时候就可以不用输入密码了(限于一完成ssh免密登录的用户)

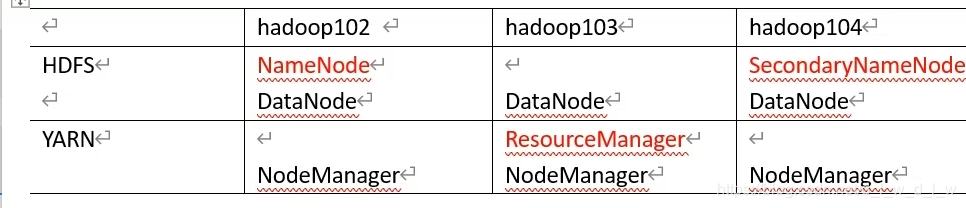

集群配置

配置核心文件

1、配置core-site.xml

<property>

<name>fs.defaultFS</name>

<value>hdfs://hadoop112:8020</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/opt/module/hadoop-3.1.3/data</value>

</property>

<!-- 配置HDFS网页登录使用的静态用户为dlw -->

<property>

<name>hadoop.http.staticuser.user</name>

<value>dlw</value>

<value>root</value>

</property>

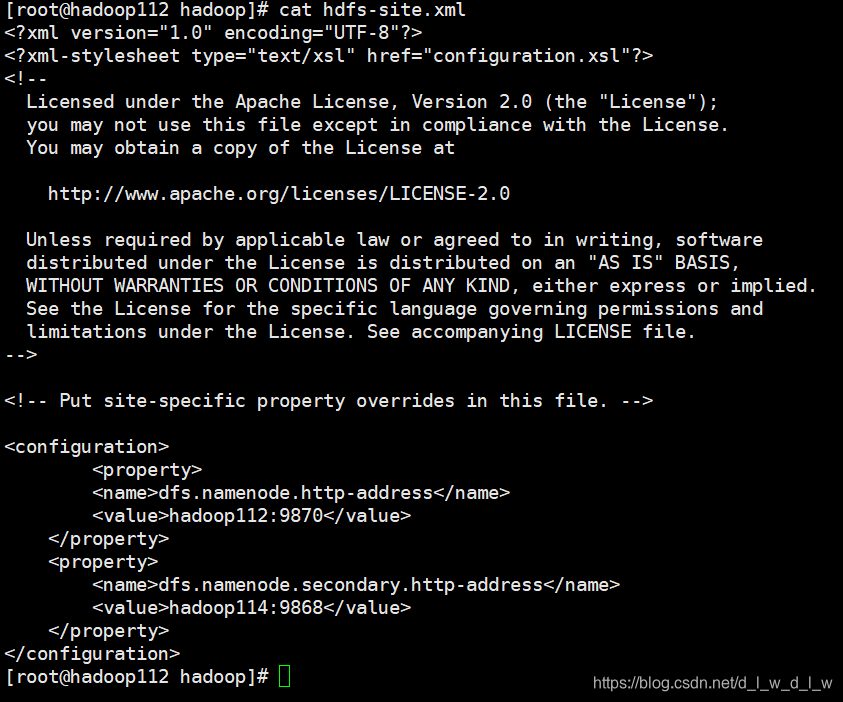

2、配置hdfs-site.xml

<property>

<name>dfs.namenode.http-address</name>

<value>hadoop102:9870</value>

</property>

<property>

<name>dfs.namenode.secondary.http-address</name>

<value>hadoop104:9868</value>

</property>

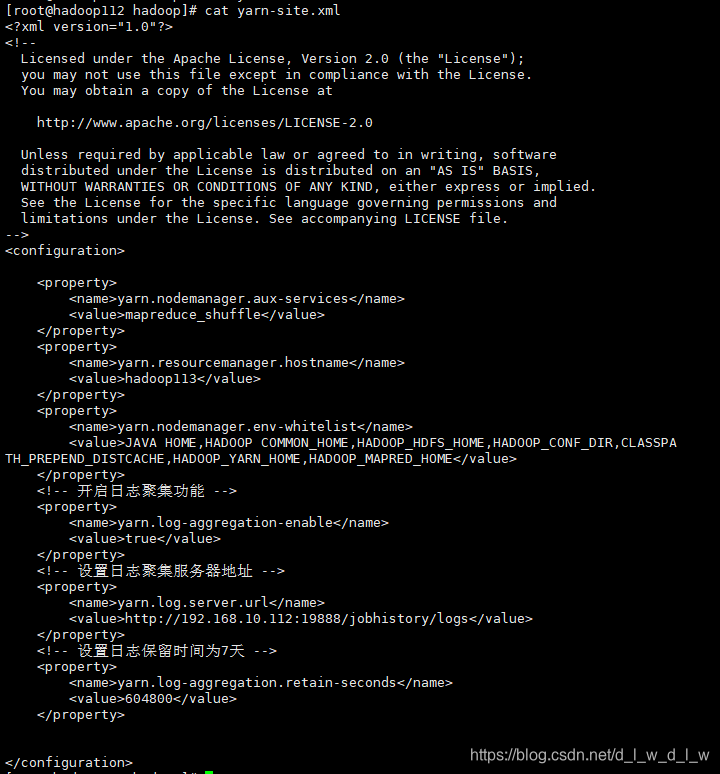

3、配置yarn-site.xml

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.resourcemanager.hostname</name>

<value>hadoop113</value>

</property>

<property>

<name>yarn.nodemanager.env-whitelist</name>

<value>JAVA HOME,HADOOP COMMON_HOME,HADOOP_HDFS_HOME,HADOOP_CONF_DIR,CLASSPATH_PREPEND_DISTCACHE,HADOOP_YARN_HOME,HADOOP_MAPRED_HOME</value>

</property>

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 设置日志聚集服务器地址 -->

<property>

<name>yarn.log.server.url</name>

<value>http://192.168.10.112:19888/jobhistory/logs</value>

</property>

<!-- 设置日志保留时间为7天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

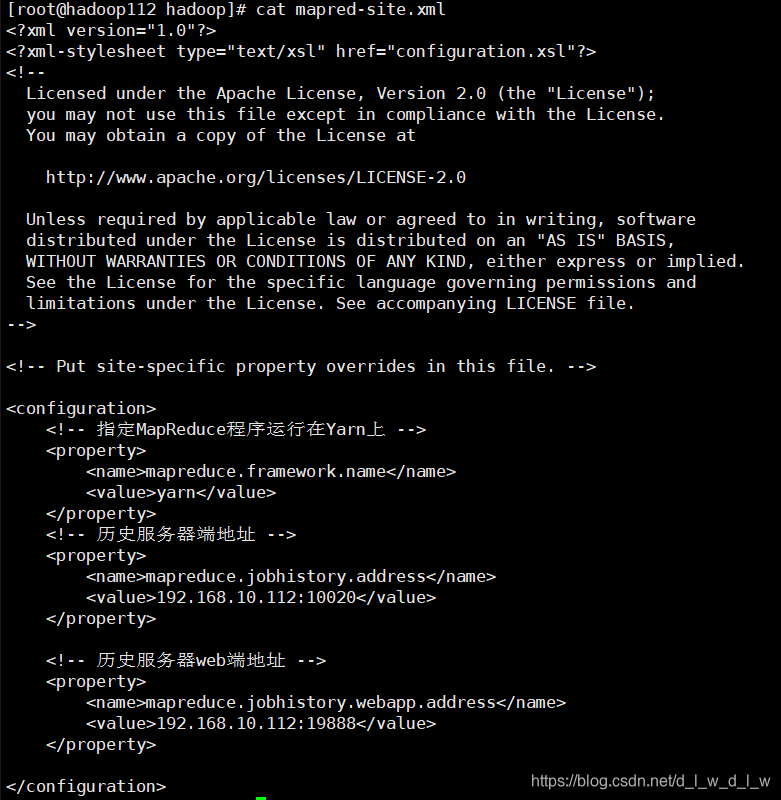

4、配置mapred-site.xml

<!-- 指定MapReduce程序运行在Yarn上 -->

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<!-- 历史服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>192.168.10.112:10020</value>

</property>

<!-- 历史服务器web端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>192.168.10.112:19888</value>

</property>

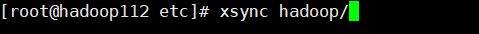

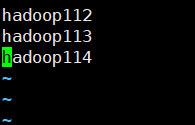

当前四部仅仅在112上完成了配置,然后使用xsync脚本将hadoop分发到113和114

群起集群

1、配置workers

在/opt/module/hadoop-3.1.3/etc/hadoop路径下编辑workers

workers中不能有任何多余的空格,不能有多余的空行。

之后用xsync脚本分发到113和114

2、启动集群

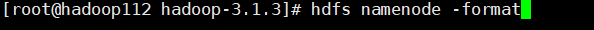

在第一次启动集群的时候需要将hadoop112的NameNode节点格式化。

配置一下root用户启动权限(112,113,114都需要进行相应的操作)

配置一下root用户启动权限(112,113,114都需要进行相应的操作)

在/opt/module/hadoop-3.1.3/etc/hadoop路径下修改hadoop-env.sh文件。

在hadoop-env.sh文件的最上方加上

export HDFS_NAMENODE_USER=root

export HDFS_DATANODE_USER=root

export HDFS_JOURNALNODE_USER=root

export HDFS_ZKFC_USER=root

export YARN_RESOURCEMANAGER_USER=root

export YARN_NODEMANAGER_USER=root

export HDFS_SECONDARYNAMENODE_USER=root

然后启动dfs

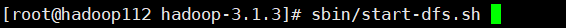

然后输入jps查看进程

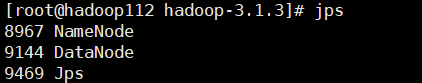

启动yarn

在hadoop113上启动yarn

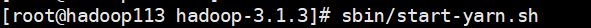

启动完成之后分别查看hadoop112,hadoop113,hadoop114的进程看是否与下表所含的进程一致。